EasyNet: An Easy Network for 3D Industrial Anomaly Detection

编辑论文链接:https://arxiv.org/pdf/2307.13925

代码链接:https://github.com/TaoTao9/EasyNet

论文来源:ACM MM 2023

背景

三维异常检测是工业制造领域(IM)一项重要的计算机视觉任务,现有的方法的问题主要体现在:

严重依赖于大型预训练模型(pretrained model),难以在生产线上部署。

由于内存库(memory bank)的过度使用而大大增加了存储开销。

由于性能问题而无法实现实时的推理。

在工业质量检测中产品的深度信息对于异常检测至关重要,但现有的异常检测方法多数基于2D图像的处理,对于一些工业产品来说,仅使用2D图像来进行异常区分是很困难的。

动机

现有的关于工业制造方向的3D异常检测依赖于大型的预训练模型和内存库,这很难在生产线上进行实时的异常推理和缺陷定位。2D图像异常检测的方法忽视了对工业产品异常检测十分重要的产品深度上的信息,使得异常检测性能下降。 提出简单且易部署的 EasyNet 模型

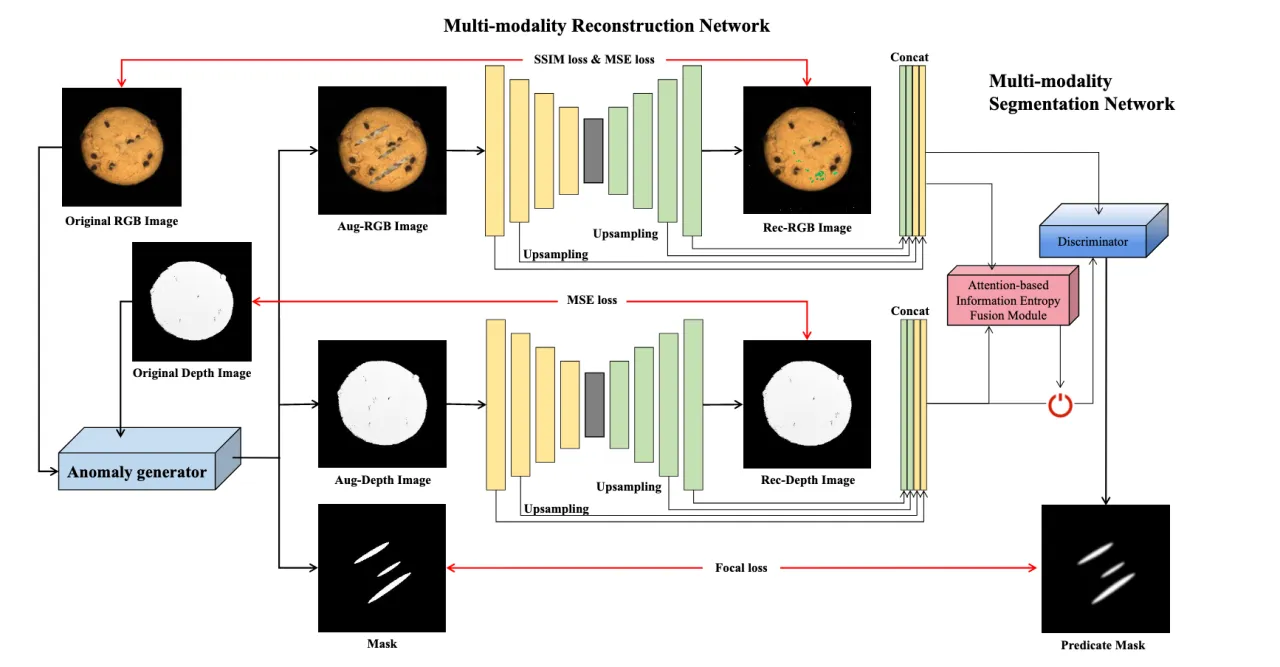

Multi-modality Reconstruction Network (MRN):精确重构异常区域分割图,促进RGB图像与深度图像(depth images)的交互。

Multi-modality Segmentation Network (MSN):实现精确的异常图。

Attention-based Information Entropy Fusion Module:基于注意力的信息熵融合模块,用于推理过程中的特征融合,使模型能实时地处理数据和做出决策。

方法

Framework

Multi-modality Reconstruction Network (MRN)

Encoder-Decoder进行原始图像重建

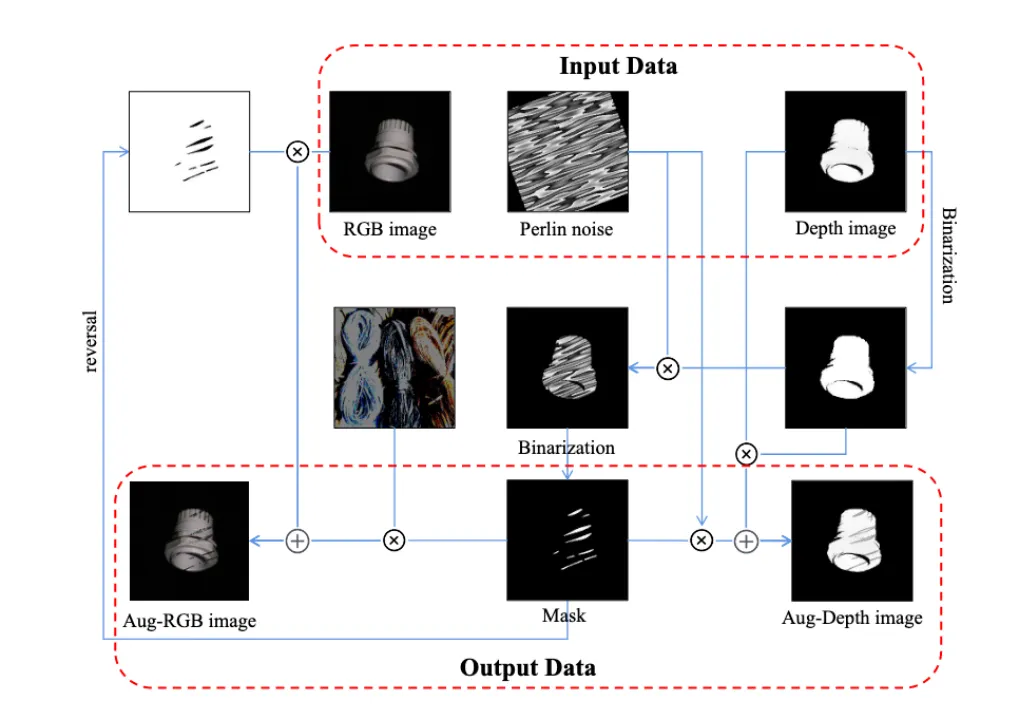

将输入图像的局部特征转换为更接近于正态样本分布的模式。 Step1:在原始深度图像上生成前景蒙版(foreground mask),并对随机生成的柏林噪声(Perlin noise)图应用蒙版操作。 Step2:对柏林噪声图进行二值化处理,生成正掩模图和负掩模图。 Step3:随机图像和原始RGB图像以及柏林噪声图和深度图像都进行加权处理。 Step4:结果输出包括带有异常和蒙版的RGB和深度图像。

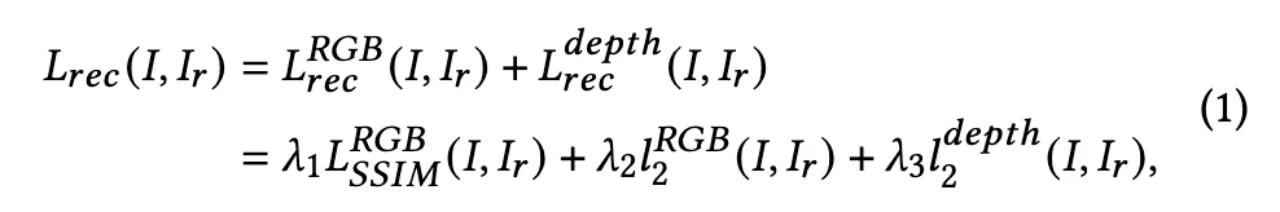

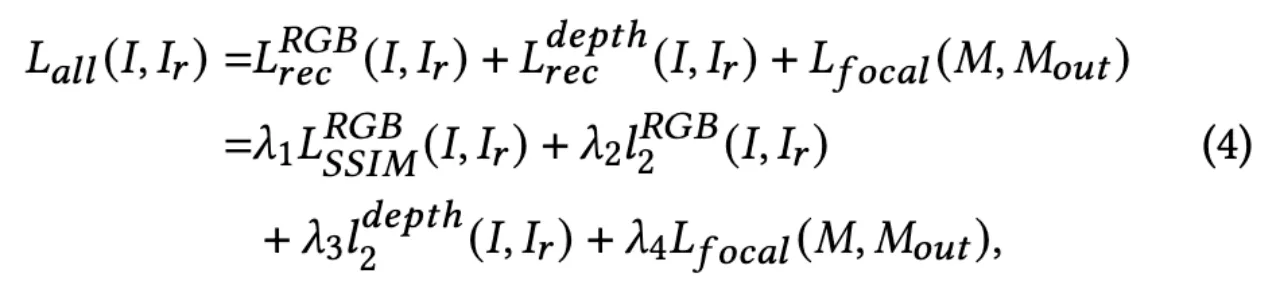

Reconstruction Loss:

Multi-modality Segmentation Network (MSN)

比较差值确定异常位置

训练集样本由模拟器处理,鉴别器识别增强图像和重构图像的输入来进行掩模(Mask)识别。

Assumption:随着多模态重建网络的深入,一些偏离正态分布的特征会逐渐被去除。

Feature Selection Strategy:在提取重构特征和增强多层图像特征时,主要采用MRN浅层网络的前三层和重构特征的后三层进行上采样操作以适应多层特征。

Method:MRN提取将由鉴别器评估的多层特征,MSN使用多层重建特征和增强图像特征比较去除前后特征值的差值得到异常的位置。

Step1:使用两层多层感知器(MLP)分别处理从RGB和深度图像中提取的多层尺度特征。

Step2:使用另一种两层MLP结构来结合两种模式的特征,并对图像中的每个像素进行正负判别。

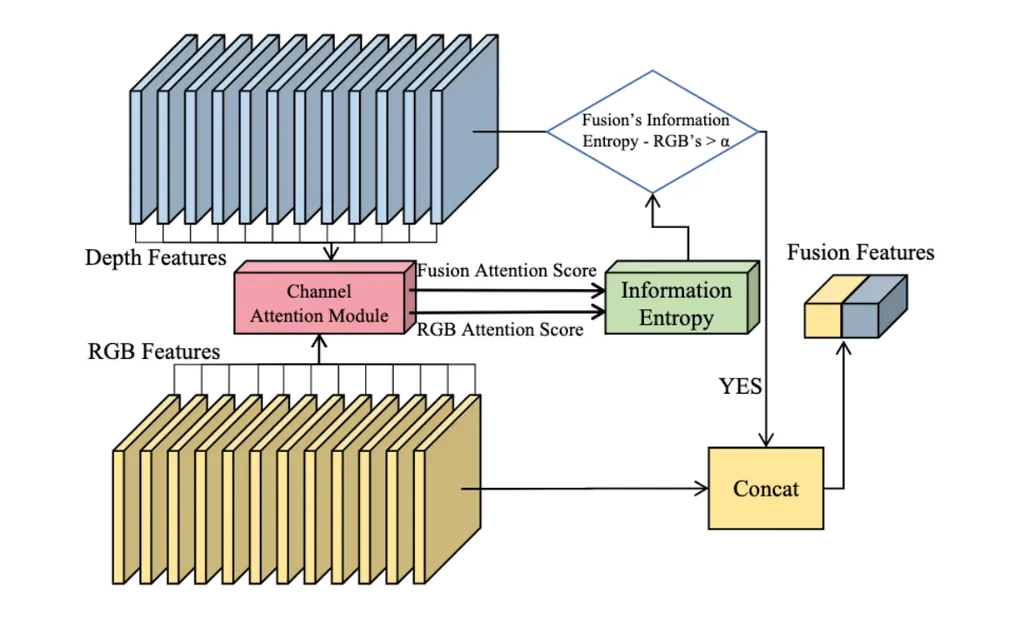

Attention-based Information Entropy Fusion Module

融合特征增强RGB特征以外的信息增益

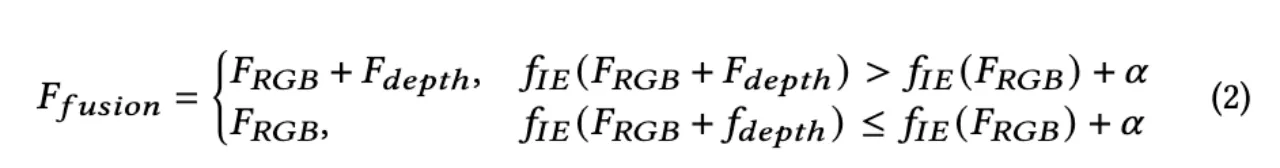

异常可能只发生在纯RGB或深度图像中,或两者兼有。Depth Feature和RGB Feature两种特征的直接结合可能会降低AD的整体表现,并导致相反的结果。 比较融合RGB和深度特征的通道与仅融合RGB特征的通道的信息熵。

Ffusion表示融合后的特征,FRGB表示RGB的特征,Fdepth表示深度特征,fIE为计算信息熵的函数,α为阈值调整因子。 如果融合特征增强了RGB特征以外的信息增益,则可以对结果的性能产生积极影响,对两个特征进行cancat,得到Fusion Feature,否则仅采用FRGB本身。

Loss Function

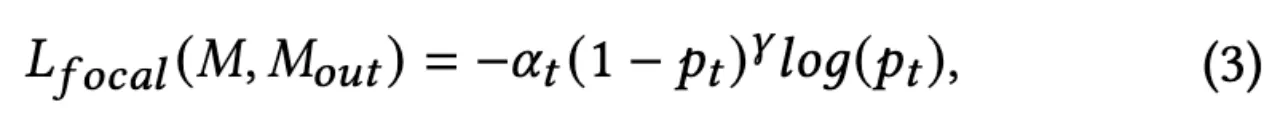

Focal Loss可以很好地解决像素单类分类时样本不平衡的问题,故使用Focal Loss计算predicted mask和ground truth mask之间的损失。

其中αt为与类别t相关的比例因子,γ为可调参数,pt对应于像素点的预测分类,异常类别为1,正常类别为0。

Overall Loss:

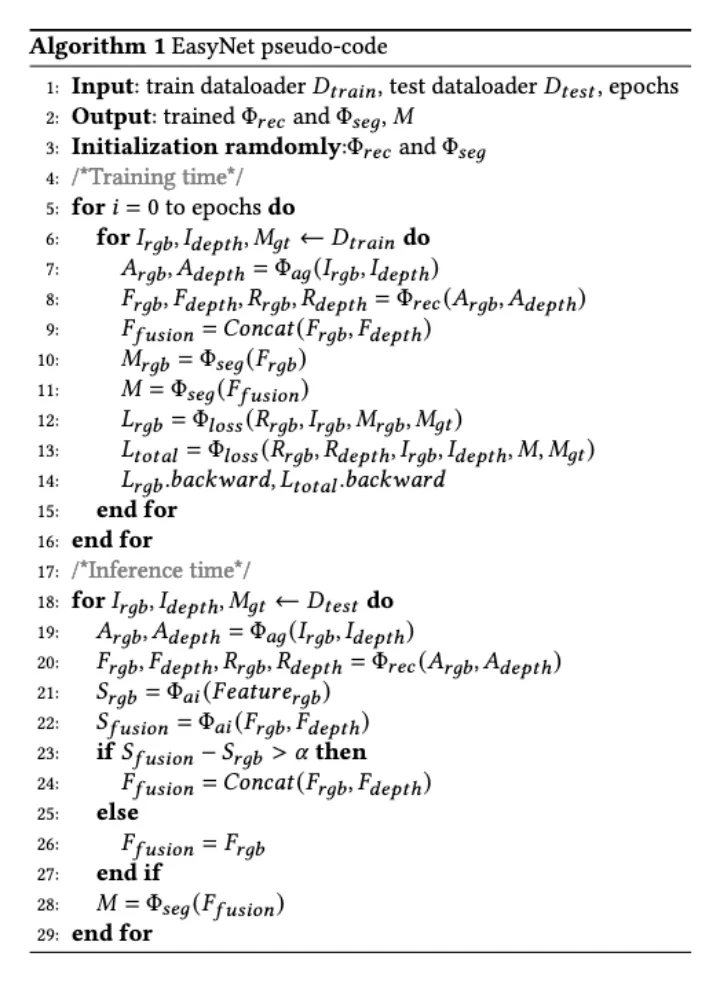

Execution Flow

Step1:在训练时,通过异常生成器Φag对图像Irgb和Idepth进行增强,分别生成增强图像Argb和Adepth。

Step2:多模态重建网络Φrec提取多尺度特征(Frgb, Fdepth),并从这些增强图像和原始图像中生成重建图像(Rrgb, Rdepth)。

Step3:多模态分割网络Φseg通过融合和纯RGB特征生成M和Mrgb的anomaly score map

Step4:在进行推理时,Φai函数分别从RGB和RGB- D通道生成相应的自注意信息熵分数,将RGB和深度特征结合起来。

实验

Datasets

MVTec 3D-AD:用于无监督异常检测和定位任务的综合3D数据集。它包含由工业3D传感器获取的超过4000次高分辨率扫描。10个不同的对象类别中的每一个都包含一组无缺陷的训练和验证样本以及一组具有各种缺陷的样本测试集。

Eyescandies:用于无监督异常检测和定位的新型合成数据集。该数据集包括十类糖果,每一类都显示出不同的复杂的纹理,自我遮挡和反射性。异常被注入到渲染图中,并自动生成像素级注释,以克服人为偏见和可能的不一致。

Metrics

AUROC(I-AUROC、P-AUROC)

AP(Image AP、Pixel AP)

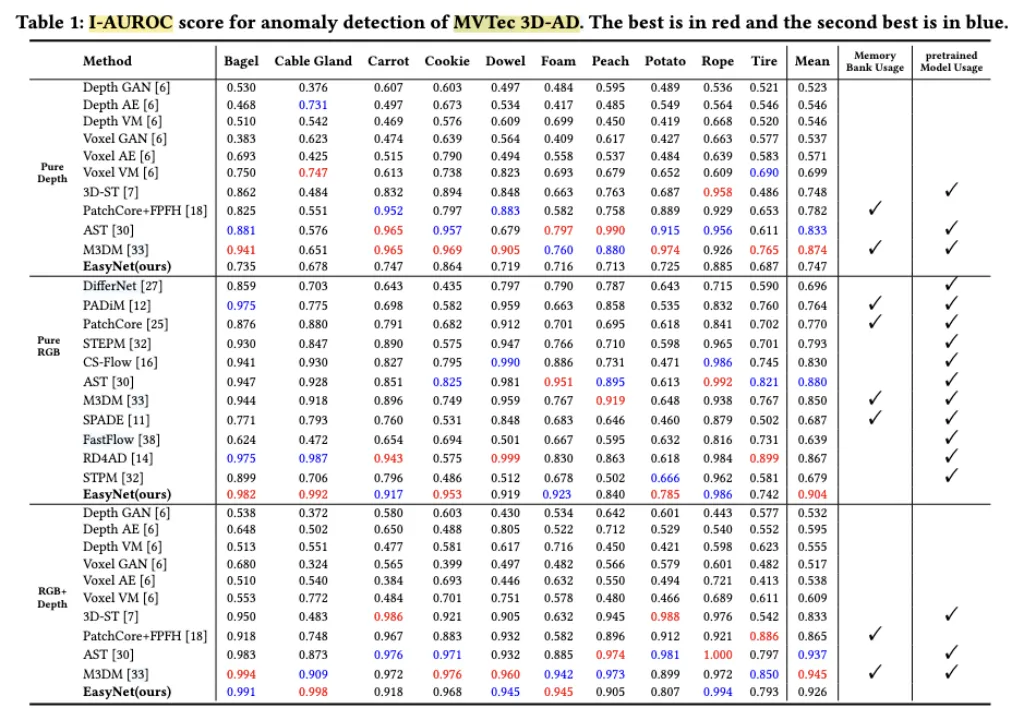

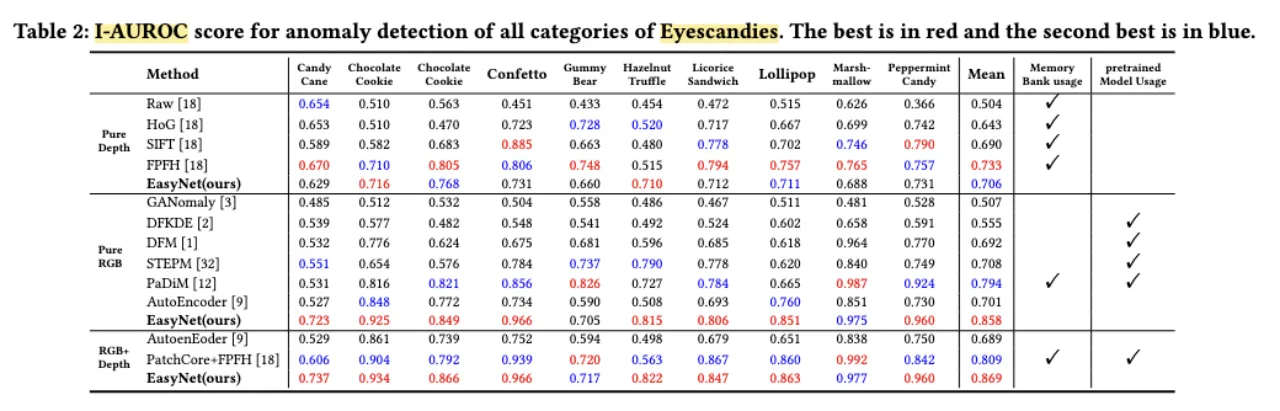

Results

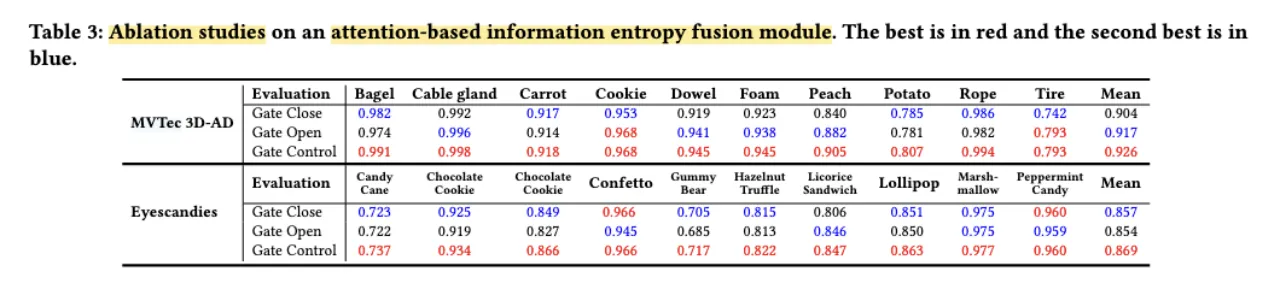

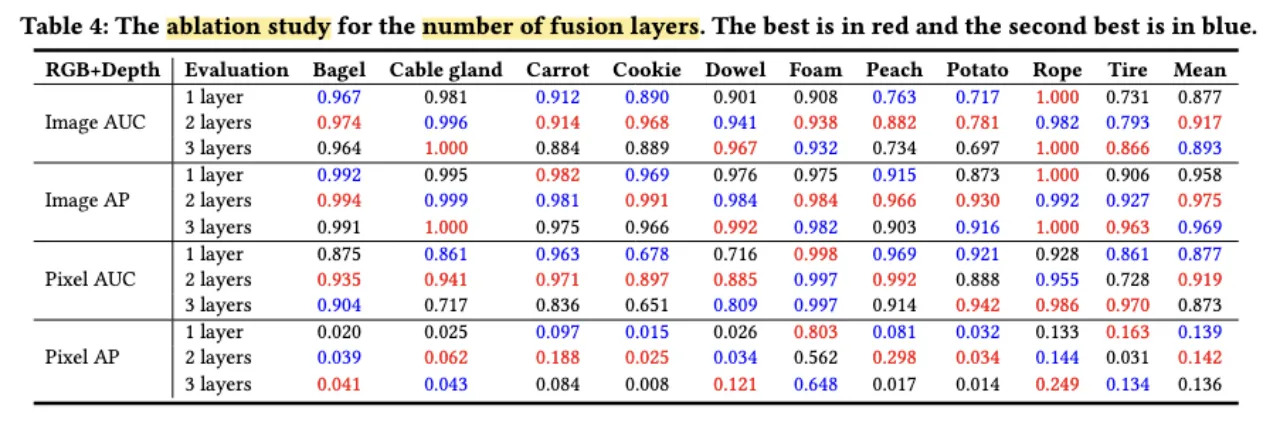

Ablation Study

Gate Close:EasyNet只使用RGB图像作为输入,而忽略深度信息。

Gate Open:同时使用RGB图像和深度图像,并结合它们的特征进行评估。

Gate Control:采用基于注意力的信息熵融合模块选择深度特征。

Gate Control取得了最好效果,证明了基于注意力的信息熵融合模块来选择特征进行融合的可行性。

使用两层特征可以获得最佳的异常检测和定位性能。使用三个特征层反而会导致性能下降,这是由于多模态重构网络的深化可以逐步消除一些异常特征部分,而三层特征对异常部分的特征去除较多,导致判别器性能较差。

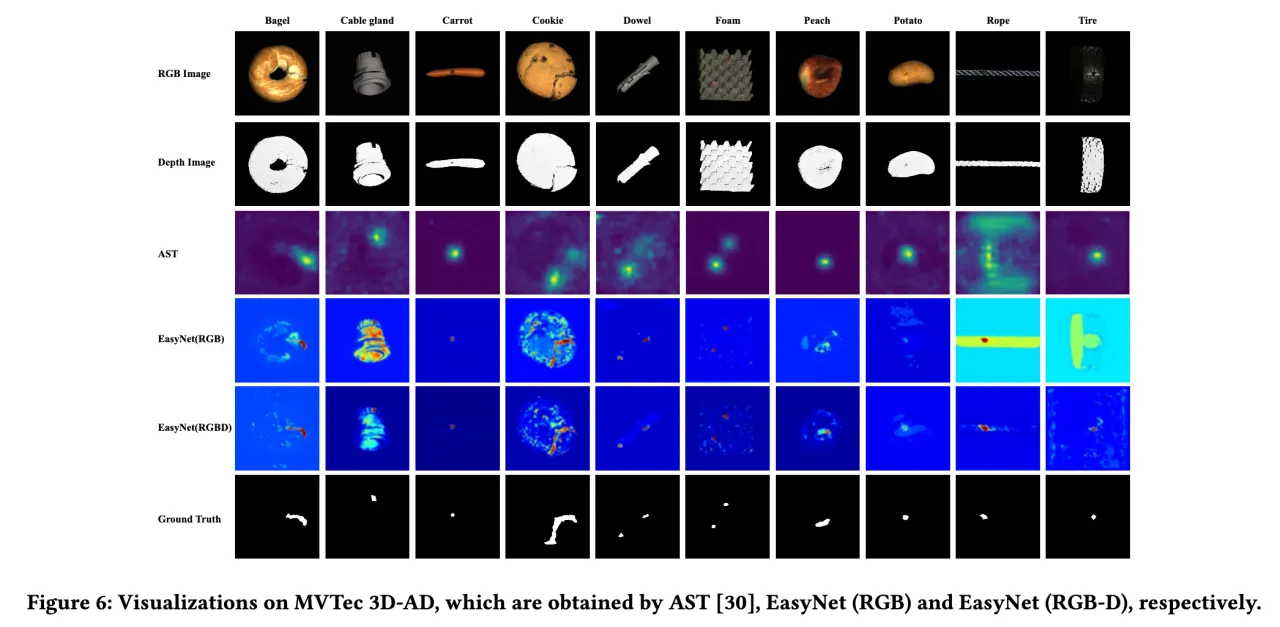

Result Visualization

总结

本文提出了一个简单但有效的神经网络EasyNet,在不使用大型预训练模型和内存库的情况下实现极好的检测性能。

EasyNet使用MRN隐式检测和重建语义上合理的无异常内容的异常,同时保持输入图像的非异常区域不变。同时提出了一种MSN算法,将重构后的RGB图像和深度图像及其原始外观拼接在一起,生成精确的异常分割图。在测试阶段,EasyNet采用融合早期的自关注信息熵评分来选择信息深度特征,然后再与RGB特征融合,在不牺牲性能的情况下实现了最快的推理速度。

EasyNet在RGB模式(即不使用深度信息)下也有不错的检测性能,可以在自己的数据集上试一下效果。

- 0

- 0

-

赞助

AliPay

WeChat Pay

WeChat Pay

-

分享